Europa pisze nowe zasady gry dla sztucznej inteligencji. Unijny AI Act, który zacznie obowiązywać w 2026 roku, to pierwsze na świecie kompleksowe prawo dające obywatelom gwarancję bezpieczeństwa, a firmom – jasne zasady gry. Francja, Niemcy i Holandia już dziś wyznaczają kierunki rozwoju etycznej sztucznej inteligencji w Europie, inwestując miliardy i testując przełomowe rozwiązania. Kluczowe staje się pytanie: jak na tym tle prezentuje się polska strategia rozwoju sztucznej inteligencji?

Rozwój sztucznej inteligencji stanowi jedno z kluczowych wyzwań XXI wieku – zarówno w wymiarze technologicznym, gospodarczym, jak i politycznym. Staje się ona coraz powszechniejsza, a jej zastosowanie w sektorze publicznym, prywatnym, a także w sferze bezpieczeństwa międzynarodowego sprawia, że państwa oraz organizacje ponadnarodowe poszukują odpowiednich mechanizmów regulacyjnych dla tej technologii. W tym kontekście szczególne znaczenie przypada Unii Europejskiej, która jako jeden z pierwszych podmiotów na arenie międzynarodowej opracowała kompleksowe ramy prawne dotyczące AI. Wyrazem tego jest AI Act – pierwszy na świecie tak szeroko zakrojony akt regulujący sztuczną inteligencję.

Sztuczna inteligencja (AI) już aktywnie funkcjonuje w kluczowych dziedzinach życia społecznego i staje się nowym polem rywalizacji w stosunkach międzynarodowych. Dla pełniejszego zrozumienia pojęcia „sztuczna inteligencja” warto przytoczyć definicję Parlamentu Europejskiego, zgodnie z którą jest to „zdolność maszyn do wykazywania ludzkich umiejętności, takich jak rozumowanie, uczenie się, planowanie i kreatywność”.

Mówiąc prościej, AI to technologia umożliwiająca komputerom „widzenie” i interpretację otaczającej rzeczywistości, podejmowanie decyzji oraz rozwiązywanie problemów. Co więcej, systemy te uczą się na podstawie wcześniejszych doświadczeń. Oznacza to, że jeśli określony sposób działania okazał się skuteczny, sztuczna inteligencja potrafi go zapamiętać i wykorzystać w przyszłości.

Jakie korzyści daje sztuczna inteligencja?

Odpowiedź na to pytanie można też znaleźć na stronie Parlamentu Europejskiego. Sztuczna inteligencja rewolucjonizuje niemal każdy aspekt naszego życia, oferując możliwości rozwiązywania problemów społecznych i gospodarczych. W medycynie pozwala na analizę ogromnych zbiorów danych, co przyczynia się do szybszego stawiania diagnoz i opracowywania spersonalizowanych terapii. Z kolei w edukacji wspiera tworzenie programów adaptacyjnych, dopasowanych do indywidualnych potrzeb uczniów. W transporcie natomiast sprzyja rozwojowi pojazdów autonomicznych, które podnoszą poziom bezpieczeństwa na drogach.

Jednak jej dynamiczny rozwój niesie ze sobą także nowe, trudne do przewidzenia ryzyka. Głównym wyzwaniem pozostaje nieprzejrzystość algorytmów. Często nie wiadomo, dlaczego system AI podjął konkretną decyzję, co swoją drogą uniemożliwia weryfikację jej uczciwości w różnych obszarach. Obecne regulacje, choć zapewniają częściową ochronę, ale nadal nie nadążają za wyzwaniami stwarzanymi przez autonomiczne systemy. To właśnie czyni przyjęcie unijnego Aktu w sprawie sztucznej inteligencji pilną i niezbędną odpowiedzią na potrzebę budowy zaufania, bezpieczeństwa i przejrzystości w erze cyfrowej transformacji.

Dodatkowo na arenie międzynarodowej sztuczna inteligencja zyskuje charakter strategiczny. Państwa inwestują w jej rozwój, aby wzmacniać swoje pozycje geopolityczne i gospodarcze. AI oddziałuje na systemy wywiadowcze i bezpieczeństwo narodowe, umożliwiając automatyczne monitorowanie wydarzeń globalnych oraz przewidywanie przyszłych zagrożeń. Co więcej, odgrywa istotną rolę w negocjacjach oraz w procesach kształtowania polityki międzynarodowej, wpływając na relacje między państwami.

Europa reguluje sztuczną inteligencję, co zmieni się w 2026 roku?

W sierpniu 2024 roku Unia Europejska uchwaliła historyczny Akt w sprawie sztucznej inteligencji (AI Act). Jest to pierwsze na świecie kompleksowe prawo regulujące wykorzystanie tej technologii. To przełomowy moment nie tylko dla biznesu i administracji publicznej, ale także dla obywateli, którzy wreszcie mają otrzymać narzędzie ochrony przed nadużyciami. Całość zacznie obowiązywać w pewnym zakresie od sierpnia 2026 roku, chociaż niektóre przepisy weszły w życie już wcześniej.

Cztery poziomy ryzyka

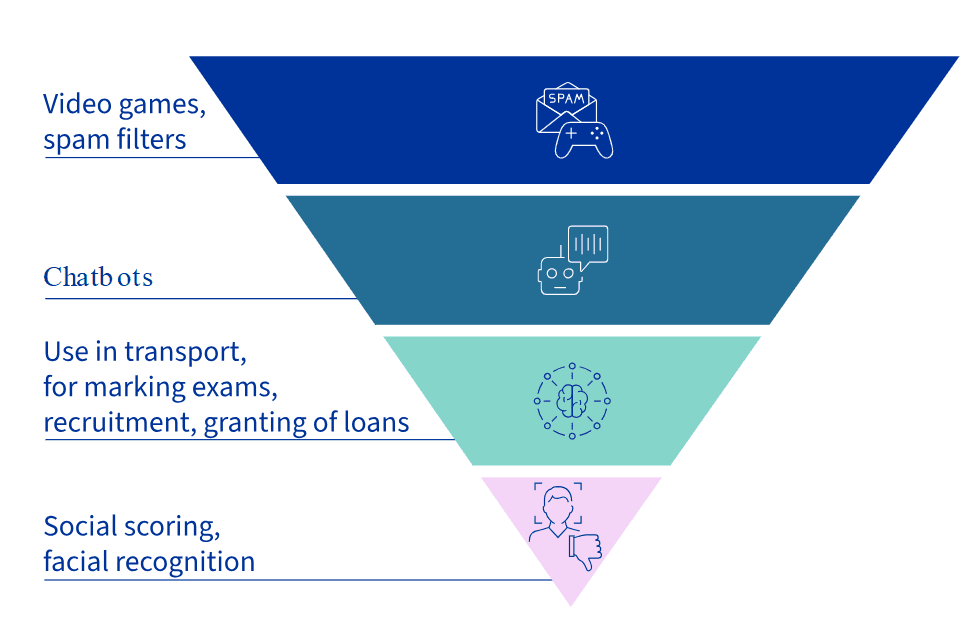

Act AI wprowadza sytem klasyfikacji sztucznej inteligencji według poziomu ryzyka. Zgodnie z nim, istnieją ich cztery poziomy – minimalne, ograniczone, wysokie oraz niedopuszczalne. Najbardziej kontrowersyjne praktyki, takie jak np. masowa biometryczna inwigilacja w czasie rzeczywistym, rozpoznawanie emocji w szkołach i miejscach pracy czy też systemy oceny obywateli, zostały całkowicie zakazane. Z kolei te wysokiego ryzyka – używane w medycynie, transporcie czy rekrutacji – będą podlegały ścisłym wymogom. Firmy wprowadzające takie systemy na rynek będą musiały zagwarantować: przejrzystość ich działania, wysoką jakość danych, możliwość audytu oraz nadzór człowieka nad decyzjami maszyn. Są też technologie ogranicznego ryzyka, takie jak chatboty, które będą musiały spełniać obowiązki informacyjne, czyli jasno komunikować użytkownikom, że rozmawiają z algorytmem, a nie z człowiekiem.

Jednak nie wszystkie regulacje zaczną obowiązywać w jednym czasie. Już od lutego 2025 roku obowiązują zakazy i obowiązki w zakresie umiejętności korzystania ze sztucznej inteligencji. Od 2 sierpnia 2025 roku zasady zarządzania i obowiązki dotyczące modeli GPAI, czyli systemów generatywnych, które mogą być wykorzystywane w wielu różnych zastosowaniach. I dopiero od sierpnia 2026 roku prawo stanie się w pełni obowiązujące, a jego egzekwowanie obejmie całą UE. Wyjątkiem są przepisy dotyczące systemów sztucznej inteligencji wysokiego ryzyka – mają przedłużony okres przejściowy do 2 sierpnia 2027 roku.

Nowe organy nadzoru

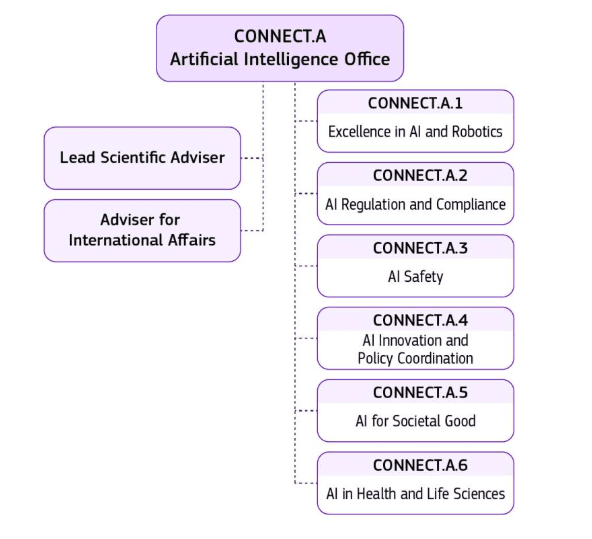

Powstać mają także nowe organy nadzorcze, gdyż przepisy wymagają stworzenia instytucji, które będą czuwać nad ich realizacją. Najważniejszą z tych instytucji jest Europejski Urząd ds. Sztucznej Inteligencji (AI Office), powołany w ramach Komisji Europejskiej. To on będzie centrum wiedzy, nadzoru i interpretacji prawa. Obok niego działać ma Europejska Rada ds. AI, skupiająca przedstawicieli państw członkowskich i koordynujących wdrażanie regulacji w całej Unii. Także każde państwo członkowskie musi utworzyć własny organ krajowy odpowiedzialny za egzekwowanie przepisów, prowadzenie audytów i nakładanie kar.

Liderzy w regulacji sztucznej inteligencji – UE

Choć AI Act jest regulacją wspólną dla całej Unii, to jednak niektóre państwa członkowskie wyróżniają się przygotowaniem instytucji i skalą inwestycji stając się faktycznymi liderami europejskiej polityki w zakresie sztucznej inteligencji.

Government AI Readiness Index 2024, to ranking, który ocenia zdolności państw w zakresie zarządzania technologią AI. Analiza obejmuje kluczowe czynniki sukcesu, takie jak zaawansowanie infrastruktury cyfrowej, sprawność administracji publicznej, jakość narodowych strategii AI, otwartość danych oraz współpracę w ramach inicjatyw międzynarodowych najwyższe miejsca zajęły: Francja (4. miejsce na świecie, 79,39 pkt), Holandia (7. miejsce, 77,23 pkt) i Niemcy (8. miejsce, 76,90 pkt). W czołówce znalazły się także Finlandia (9. miejsce, 76,48 pkt), Szwecja (14. miejsce, 75,40 pkt) i Dania (15. miejsce, 74,71 pkt). Polska uplasowała się dopiero na 34. pozycji z wynikiem 67,51 pkt.

Ambicje, kontrowersje, etyka: francuskie laboratorium regulacji sztucznej inteligencji.

Francuska strategia sztucznej inteligencji sięga 2017 roku, kiedy powstała „Krajowa Strategia na rzecz AI” – integralna część planu „France 2030”. Strategia ma na celu wzmocnienie francuskiej suwerenności gospodarczej, technologicznej i politycznej w obszarze AI. Na rozwój innowacyjnych technologii przeznaczono łącznie 100 miliardów euro, z czego 1,5 miliarda euro bezpośrednio na AI.

Prawdziwym testem dla francuskiego podejścia do regulacji okazały się przygotowania do Letnich Igrzysk Olimpijskich w Paryżu w 2024 roku. Specjalna ustawa z maja 2023 roku zezwoliła na eksperymentalne wykorzystanie systemów monitoringu wideo opartych na AI. Kamery analizowały w czasie rzeczywistym zdarzenia takie jak porzucenie przedmiotów czy zagęszczenie tłumu. Mimo formalnego zakazu stosowania identyfikacji biometrycznej, rozwiązanie wzbudziło poważne wątpliwości. Francuski organ ochrony danych (CNIL) ostrzegał przed ryzykiem dyskryminacji i brakiem jasnej odpowiedzialności prawnej.

Ambicje Francji sięgają jednak jeszcze dalej. Podjęto tam próbę regulacji na poziomie konstytucyjnym, rozważając wpisanie do ustawy zasadniczej zapisów potwierdzających nadrzędność człowieka nad maszyną – wpisanie do preambuły Kostytucji, Karty Etycznej AI. Choć projekt nie został przyjęty, świadczy to o rosnącej potrzebie zabezpieczenia fundamentalnych kwestii etycznych w erze AI.

Także we Francji sztuczna inteligencja nie może być autorem ani właścicielem praw autorskich. Zgodnie z prawem, przysługują one wyłącznie osobom fizycznym lub prawnym.

A proponowana ustawa nr 1630 z 2023 roku wprowadza dodatkowe obowiązki. Twórcy wykorzystujący AI mają oznaczać wygenerowane treści, opłacać je na rzecz organizacji zbiorowego zarządzania oraz przestrzegać praw autorskich podczas trenowania modeli.

Etyka, innowacje, zaufanie: niemiecki model odpowiedzialnej sztucznej inteligencji.

Z kolei rząd Niemiec już w 2018 roku przyjął Narodową Strategię AI, zaktualizowaną dwa lata później. Berlin stawia na koncepcję „AI zorientowanej na człowieka” (human-centred AI). Kładąc nacisk na wsparcie ludzi zamiast ich zastępowania, szczególnie w obszarach takich jak medycyna czy ochrona środowiska.

Na poziomie prawnym Niemcy wprowadzają innowacyjne mechanizmy, takie jak „piaskownice regulacyjne” (regulatory sandboxes), które pozwalają testować technologie AI w kontrolowanych warunkach. Kraj pracuje równolegle nad „znakiem zaufania AI” (AI trust label) oraz krajową mapą standaryzacji, które mają zapewnić spójne i przejrzyste standardy.

AI po holendersku: Demokracja, transparentność i etyka w erze algorytmów

Holenderskie regulacje sztucznej inteligencji łączą w sobie technologię, gospodarkę i ochronę praw obywateli. Ich celem jest stworzenie środowiska, w którym AI rozwija się w sposób odpowiedzialny, przejrzysty i zgodny z wartościami demokratycznymi. Podstawą tego podejścia jest także koncepcja „AI zorientowanej na człowieka”, która stawia interes publiczny i ochronę jednostki ponad samą automatyzację. Rząd aktywnie wspiera inicjatywy badawcze i instytucjonalne, mające na celu analizę etycznych i prawnych aspektów wykorzystania AI.

Więcej na temat: Netherlands AI Strategy Report – European Commission

Wizytówką holenderskiego podejścia jest Rejestr AI. To innowacyjne narzędzie umożliwia obywatelom sprawdzenie, jakie algorytmy stosuje administracja publiczna i na jakiej podstawie podejmowane są decyzje. Holandia inwestuje także w unikalne inicjatywy badawcze, takie jak laboratoria ELSA, które analizują etyczne i prawne aspekty AI. Kraj także aktywnie uczestniczy w pracach nad unijnym AI Act i jednocześnie angażuje się w globalne inicjatywy na rzecz etycznej sztucznej inteligencji.

Polska wobec AI Act

Polski rząd przyjął kompleksową „Politykę rozwoju sztucznej inteligencji w Polsce do 2030 roku” przygotowaną przez Ministerstwo Cyfryzacji. Jej celem jest sprawne wdrożenie i wykorzystywanie technologii AI w kluczowych obszarach życia. Także dokument ten jest odpowiedzią na dynamiczną rewolucję technologiczną oraz strategiczne inicjatywy UE, takie jak rozporządzenie AI Act czy koncepcja „Kontynentu AI” (AI Continent) zaprezentowana przez Komisję Europejską w kwietniu 2025 roku.

Kontynent AI „ma na celu wzmocnienie innowacyjności UE w zakresie AI poprzez pięć kluczowych obszarów. Po pierwsze, rozwijana będzie infrastruktura danych i obliczeń, m.in. poprzez tworzenie Fabryk AI wokół superkomputerów oraz budowę Gigafabryk AI wyposażonych w około 100 000 chipów, wspieranych inwestycjami z programu InvestAI. Po drugie, zwiększony zostanie dostęp do wysokiej jakości danych dzięki tworzeniu Data Labs oraz strategii Data Union. Trzecim filarem jest rozwój algorytmów i wdrażanie AI w sektorach strategicznych poprzez inicjatywę Apply AI, przy wsparciu Fabryk AI i Europejskich Centrów Innowacji Cyfrowych (EDIH). Czwarty filar to wzmacnianie kompetencji i przyciąganie talentów poprzez programy stypendialne, AI Skills Academy, a także edukację i szkolenia w dziedzinie AI. Ostatni obszar to uruchomienie AI Act Service Desk, który zapewni przedsiębiorstwom wsparcie i wskazówki dotyczące zgodności z przepisami AI Act.” – Polityka rozwoju sztucznej inteligencji w Polsce do 2030 roku, Ministerstwo Cyfryzacji.

Wyzwania stojące przed Polską

Warto zaznaczyć, że plan rozwoju AI nie powstał w próżni. Uwzględnia on wiele innych rządowych dokumentów z innych obszarów, takich jak np. gospodarka i produktywność (Strategia Produktywności 2030), obronność (Resortowa strategia Sztucznej Inteligencji MON), zdrowie cyfrowe oraz ogólnego rozwoju kraju (strategia do 2035 roku). Prace nad tą Polityką opierały się na analizach i rekomendacjach ekspertów z Polskiego Instytutu Ekonomicznego i Grupy Roboczej ds. AI (GRAI). Jak Ministerstwo Cyfryzacji podkreśla:

„Polska ma szansę zostać jednym z państw najlepiej korzystających z możliwości tworzonych przez rozwój AI. Ten scenariusz wymaga jednak strategicznych działań w obszarach takich, jak: inwestycje, edukacja, regulacje czy budowa przyjaznego ekosystemu współpracy nauki i biznesu.”

Realizacja tej wizji napotyka jednak na znaczące wyzwania. Z danych Eurostatu za 2024 rok wynika, że jedynie 5,9% polskich przedsiębiorstw wykorzystuje technologie AI. To plasuje Polskę na jednym z ostatnich miejsc w Unii Europejskiej, daleko za liderami takimi jak Dania (27,6%) czy Szwecja (25,1%). Dodatkowo, kraj boryka się z poważną luką kadrową w sektorze ICT (Technologie Informacyjne i Komunikacyjne), gdzie specjaliści stanowią zaledwie 4,3% wszystkich zatrudnionych, a deficyt utalentowanych pracowników potęguje zjawisko „drenażu mózgów” inaczej mówiąc – „emigracji utalentowanych specjalistów do innych krajów”.

Polska zamierza zbudować skoordynowany ekosystem godnej zaufania AI, który wspiera rozwój gospodarki i dobrostanu społecznego. Kluczowym jego elementem ma być nowoczesna infrastruktura. Plany obejmują budowę dwóch krajowych Fabryk AI (w tym Fabryki AI „Piast” w Poznaniu) oraz dołączenie do unijnego programu Gigafabryk AI. Inwestycje te, wraz z rozbudową istniejących systemów, mają zapewnić niezbędną moc obliczeniową do trenowania zaawansowanych modeli, w tym pierwszego publicznego polskiego modelu językowego o nazwie PLLuM.

Polska może się przy tym pochwalić silną pozycją w obszarze danych otwartych. Zgodnie z raportem Open Data Maturity (przygotowany przez Komisję Europejską), zajmuje 2. miejsce w Europie. –

„Otwarte dane umożliwiają niskokosztowe trenowanie algorytmów, co jest szczególnie cenne dla mniejszych firm technologicznych i startupów”.

Wdrażanie AI w sektorze publicznym

Równolegle prowadzone są intensywne działania w sferze edukacji i kształcenia talentów. Już w maju 2025 r. do szkół trafiło 16 tys. pracowni AI oraz pracowni nauk przyrodniczych, technologii, inżynierii i matematyki. A docelowo narzędzia te mają być dostępne we wszystkich publicznych szkołach i uczelniach.

Sektor publiczny ma być wiodącym przykładem wdrażania rozwiązań AI. Centralną platformą zarządzania tymi technologiami ma być AI HUB Poland, projekt realizowane przez grupę ekspertów Centralnego Ośrodka Informatyki i NASK i innych partnerów. Ma on wspierać budowę cyfrowego Państwa, rozwój gospodarki oraz konkurencyjności na arenie międzynarodowej.

Planowane jest także wdrożenie wirtualnego asystenta opartego na AI w aplikacji mObywatel oraz innych platformach rządowych. Szczególny nacisk położony jest na newralgiczne obszary usług publicznych, takie jak ochrona zdrowia i wymiar sprawiedliwości. W zdrowiu AI ma wspomóc diagnostyce i personalizacji leczenia, korzystając z danych z europejskiej przestrzeni danych zdrowotnych (EHDS). W sądownictwie natomiast priorytetem jest dokończenie digitalizacji akt.

„Dziś akta sądowe wciąż są prowadzone w formie papierowej, co uniemożliwia trenowanie modeli AI na rzeczywistych danych”. – Ministerstwo Cyfryzacji.

Kluczowe sektory gospodarki

Dla pobudzenia gospodarki, Polski Instytut Ekonomiczny, Grupa Roboczy ds. AI i inne raporty i dokumenty strategiczne wskazują na sektory o największym potencjale dla wdrożeń AI. Do których należą m.in.: energetyka, e-commerce, cyberbezpieczeństwo, usługi finansowe oraz transport i logistyka. Dla każdego z tych sektorów mają zostać opracowane dedykowane polityki sektorowe we współpracy z Ministerstwem Rozwoju i Technologii oraz właściwymi resortami.

Warto zaznaczyć, że realizacja tak szeroko zakrojonych planów wymaga znaczącego finansowania. Środki pochodzić będą z różnych źródeł, w tym z funduszy unijnych (np. programy SMART o budżecie 1,3 mld zł, INFOSTRATEG – 500 mln zł, STEP – 3,8 mld zł), Krajowego Planu Odbudowy (1,2 mld zł na zdrowie) oraz budżetu państwa (60 mln zł w 2025 r. na budowę Fabryk AI). A nadzór nad zasadnością wydatków pełnić będzie Rada Funduszy Sztucznej Inteligencji.

Zaufanie do technologii AI

Niezwykle istotnym aspektem całej strategii jest także budowa zaufania do technologii AI. Polska zobowiązuje się do rozwoju AI zorientowanej na człowieka, wolności, demokracji, praworządności, uczciwej konkurencji, oraz wolności nauki i badań oraz innowacji. Planowane jest wdrożenie odpowiednich norm, powołanie systemu nadzoru rynku, a także uruchomienie mechanizmu umożliwiającego obywatelom składanie skarg na działanie systemów AI.

W wyniku „Polityka rozwoju sztucznej inteligencji w Polsce do 2030 roku” stanowi kompleksowy plan transformacji cyfrowej. Jej sukces zależy od skutecznej koordynacji między administracją, światem nauki, biznesem i społeczeństwem.

Źródło zdjęcia nagłówka: wygenerowane przez ChatGPT

O autorze

Absolwentka stosunków międzynarodowych i studentka dziennikarstwa i medioznawstwa na Uniwersytecie Warszawskim. Najbardziej interesuje mnie polityka międzynarodowa, funkcjonowanie organizacji międzynarodowych, rola mediów w społeczeństwie oraz rola nowych technologii w kształtowaniu współczesnych procesów społecznych i politycznych.

Fajny artykuł! Szczególnie podobał mi się ten skrót informacji o AI Act 🙂

Możliwość komentowania została wyłączona.